Music

Latest Recording

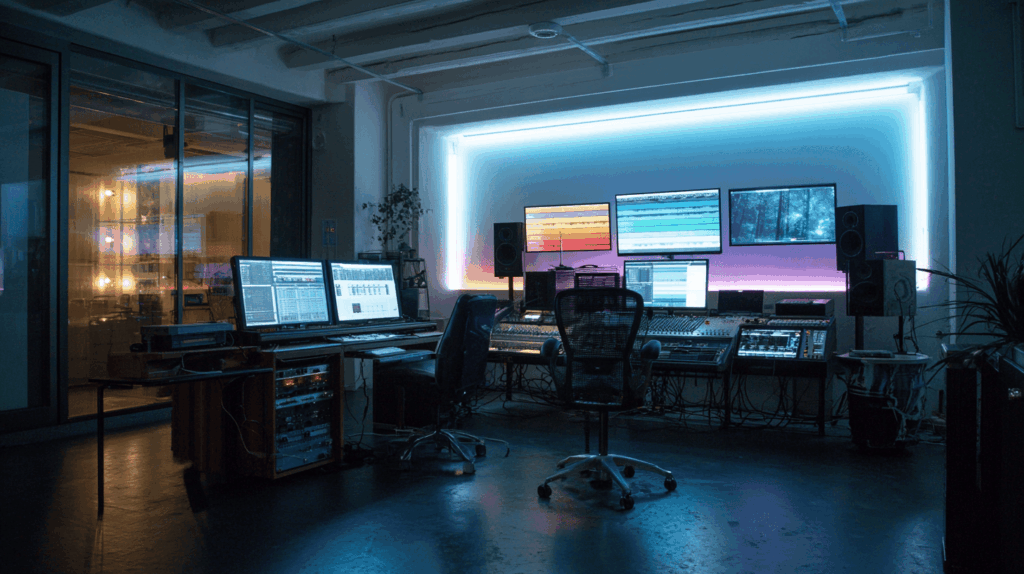

Eine KI-gestützte Musikproduktion in Studioqualität kombiniert modernste Technologie mit klassischem Tonstudiowissen und verläuft in mehreren präzise aufeinander abgestimmten Phasen. Der gesamte Prozess beginnt mit der kreativen Konzeption und endet mit dem finalen Mastering – alles so aufgebaut, dass die resultierende Musik den Standard professioneller Produktionen erreicht.

1. Konzeptphase und Datenbasis:

Am Anfang steht die Definition von Stil, Genre und Stimmung. Hier wird festgelegt, ob das Endprodukt ein Popsong, ein orchestrales Werk, ein Schlager oder ein elektronischer Track wird. Die KI benötigt eine Trainingsbasis: bestehende Musikstücke, Samples, MIDI-Daten oder eigens erstellte Referenz-Tracks. Diese Daten werden in ein neuronales Netzwerk eingespeist, das musikalische Muster wie Harmonie, Rhythmik und Dynamik analysiert.

2. KI-Komposition und Arrangement:

Auf dieser Grundlage generiert die KI erste Kompositionsideen. Dies geschieht meist in Form von MIDI-Daten oder mehrspurigen Audioentwürfen. In einem virtuellen „Kompositionsraum“ entscheidet das System über Akkordfolgen, Melodielinien, Instrumentierung und Songstruktur (Intro, Verse, Refrain, Bridge). Der Produzent greift in dieser Phase ein, wählt passende Variationen, kombiniert KI-Outputs und setzt manuelle Akzente, um Individualität sicherzustellen.

3. Sound Design und Instrumentierung:

Sobald das Grundgerüst steht, werden die virtuellen Instrumente und Sounds auf Studio-Niveau gewählt. Hochwertige VST-Plugins und Libraries kommen zum Einsatz – von orchestralen Strings über analoge Synthesizer bis zu realistischen Drumsets. Die KI kann automatisch Layer erzeugen, z. B. subtile Pads für Tiefe oder rhythmische Percussion-Elemente. Hier beginnt die Arbeit im „Mix-in-the-Box“-Stil, ähnlich wie in einem echten Tonstudio.

4. Recording-Phase:

Falls Vocals oder Live-Instrumente benötigt werden, erfolgt jetzt die Aufnahme. Im Studio wird mit professionellen Kondensatormikrofonen, Pre-Amps und akustischer Optimierung gearbeitet. KI-gestützte Tools können Echtzeit-Feedback geben: Tonhöhenkorrektur, Timbre-Optimierung oder sogar die Simulation verschiedener akustischer Räume. Bei rein KI-generierten Vocals kommen neuronale Sprach- und Gesangssynthesen zum Einsatz, die menschliche Stimmen täuschend echt imitieren.

5. Editing und Feinschliff:

Die einzelnen Spuren werden bereinigt, geschnitten und aufeinander abgestimmt. Hier spielt die KI eine große Rolle: Automatische Quantisierung, Timing-Korrektur, intelligentes Noise-Reduction und Harmonie-Anpassung sorgen für ein sauberes Ausgangsmaterial. In einem Studio-Workflow entspricht dies dem klassischen „Comping“ und Editing von Takes.

6. Mixing:

Im Mixdown werden alle Spuren klanglich miteinander verschmolzen. KI-gestützte Mix-Engines analysieren Frequenzen, Lautstärken und Stereobreite und schlagen optimale Einstellungen vor. Dennoch bleibt der menschliche Produzent entscheidend: EQ, Kompression, Hallräume und Effekte werden so gesetzt, dass der Song emotionale Tiefe und Professionalität erhält. Hochwertige Abhörmonitore und Raumakustik sind hier Pflicht.

7. Mastering:

Im finalen Schritt wird der fertige Mix auf verschiedene Abspielplattformen optimiert – von Spotify über Radio bis hin zu Vinyl. KI-Mastering-Tools analysieren Referenz-Tracks und passen Lautheit, Dynamik und Frequenzspektrum an Industriestandards an. Limiter, Multiband-Kompression und Stereo-Enhancement sorgen für einen druckvollen, ausgewogenen Klang.

8. Export und Distribution:

Das Endprodukt wird in allen relevanten Formaten (WAV, MP3, FLAC) exportiert und metadatenoptimiert. KI-Systeme können direkt mit Distributionsplattformen verbunden sein und übernehmen Artwork-Erstellung, Metadatenpflege und Upload.

Dieser Prozess verbindet klassische Studiotechnik mit künstlicher Intelligenz und schafft so Musik auf höchstem Niveau. Die KI dient als kreativer Partner und technischer Assistent, während der Produzent die finale künstlerische Handschrift setzt.